Dolly by Databricks Projesi, Yapay Zeka Örnekleri

Dolly by Databricks

Dolly by Databricks Hakkında

Dolly by Databricks Hakkında

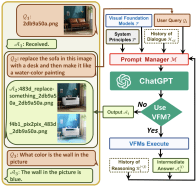

Databricks'in Databricks Makine Öğrenimi Platformunda eğitilmiş büyük bir dil modeli olan Dolly, iki yıllık bir açık kaynak modelinin ( GPT-J ) 50.000 kayıtlık odaklanmış bir külliyatta yalnızca 30 dakikalık ince ayara tabi tutulduğunda bunu yapabileceğini gösteriyor. ( Stanford Alpaca https://gpt3demo.com/apps/stanford-alpaca), dayandığı temel modelin özelliği olmayan davranışı takiben şaşırtıcı derecede yüksek kaliteli talimat sergiliyor. Databrick, bu bulgunun önemli olduğuna inanıyor çünkü güçlü yapay zeka teknolojileri yaratma yeteneğinin daha önce gerçekleştirilenden çok daha erişilebilir olduğunu gösteriyor.

Eğitim Verileri, Önyargı ve Sakıncalı İçerik

Tüm dil modelleri gibi, dolly-v1-6b de eğitim külliyatının içeriğini ve sınırlamalarını yansıtır.

Yığın: GPT-J'nin eğitim öncesi külliyatı, çoğunlukla halka açık internetten toplanan içeriği içerir ve çoğu web ölçeğindeki veri kümesi gibi, birçok kullanıcının sakıncalı bulacağı içeriği içerir. Bu itibarla, modelin bu kusurları, potansiyel olarak açık bir şekilde sakıncalı içerik üretmesi istendiğinde ve bazen de önyargılı veya zararlı örtük çağrışımlar durumunda olduğu gibi üstü kapalı olarak yansıtması muhtemeldir.

Stanford Alpaca: Dolly-6b için talimat ayarlama korpusunun birçok sınırlamayı paylaştığı varsayılabilir. Ayrıca, diğer veri eksikliklerinin yanı sıra olgusal yanlışlıklar, anlamsal ve sözdizimsel düzensizlikler, anlamsız cevaplar ve yanlış matematiksel hesaplamalar içerdiği bilinmektedir. Model çıktıları bu sınırlamaları yansıtacaktır.